DeepSeek大模型历史及概述

一、DeepSeek公司

DeepSeek公司 成立于2023年7月17日,中文名字全称是 杭州深度求索人工智能基础技术研究有限公司 ,由知名量化基金公司 幻方量化 创立(注册总资本1000万,幻方量化的创始人梁文锋占了1%的持股比例)。DeepSeek 作为一家创新型科技公司,成立以来专注于开发先进的大语言模型(LLM)和相关技术,作为大厂外唯一一家储备万张 A100 芯片的公司,幻方量化为DeepSeek的技术研发提供了强大的硬件支持。

幻方量化 公司由三名毕业于浙江大学的工程师(其中就包括梁文锋)于2015年创立,是一家总部位于中国浙江省杭州市的对冲基金、量化基金和人工智能公司。2017年幻方量化开始基于机器学习进行交易,并宣称实现投资策略全面AI化。此后的2023年7月创立DeepSeek 公司,所以说DeepSeek 公司是幻方量化公司的子公司。

二、DeepSeek公司的模型历史

此章节按照时间顺序阐述DeepSeek公司发布的重要模型的概述信息。后面有单独的章节把DeepSeek-V3及DeepSeek-R1模型的概述、特征、模型下载等进行说明。

DeepSeek LLM

2024年1月5日,发布第一个模型DeepSeek LLM。此模型包含670亿参数,在一个包含2万亿token的数据集上进行了训练,数据集涵盖中英文。为了促进研究社区,公司全部开源了DeepSeek LLM 7B/67B Base和DeepSeek LLM 7B/67B Chat。DeepSeek LLM的主要特征有如下:

- 卓越的综合能力:DeepSeek LLM 67B Base在推理、编码、数学和中文理解等方面超越了Llama2 70B Base。

- 精通编程和数学:DeepSeek LLM 67B Chat在编码和数学方面表现出色。

- 精通中文:DeepSeek LLM 67B Chat在中文表现上超越了GPT-3.5。

其他详细介绍参考:DeepSeek-LLM的代码仓库

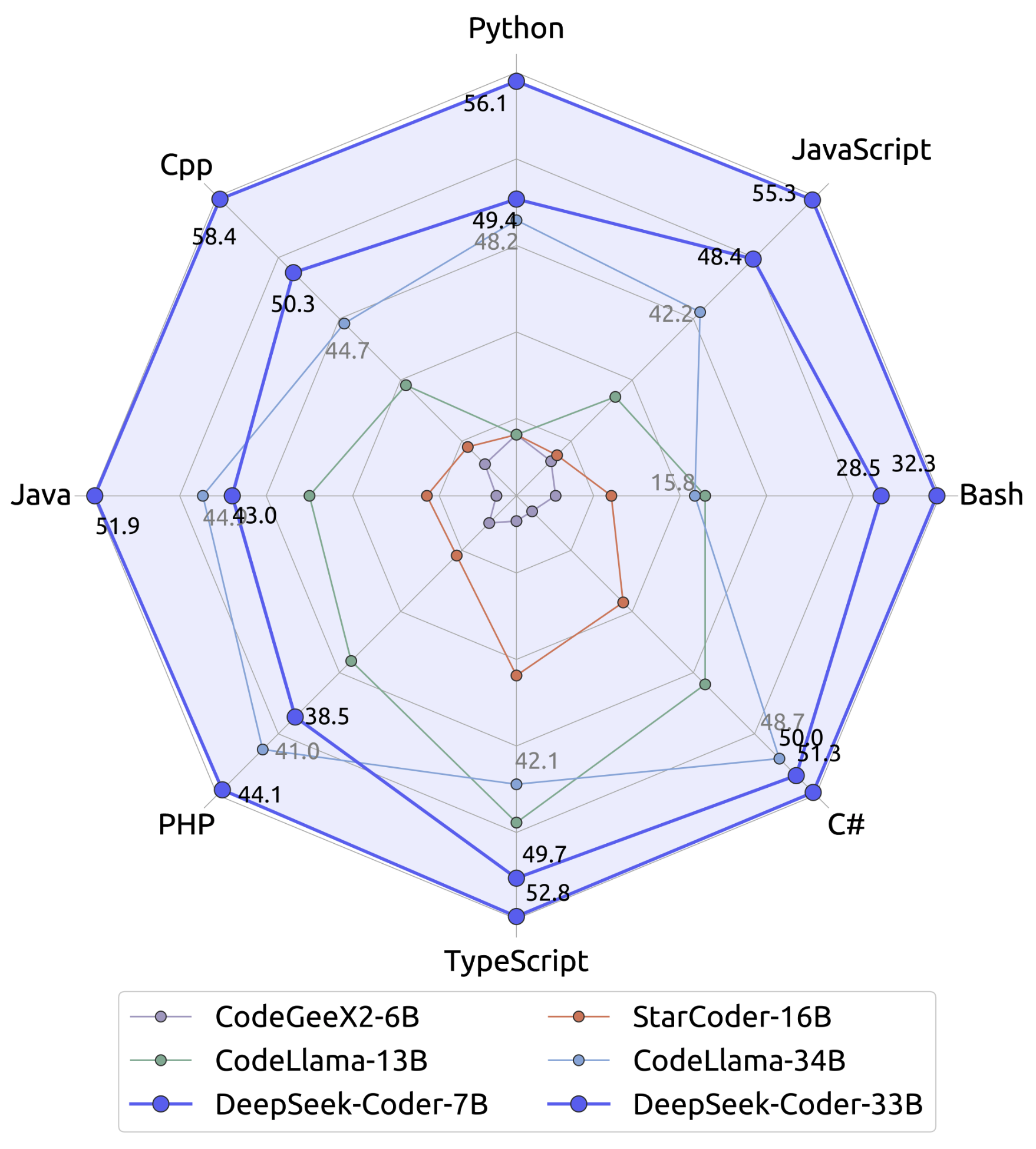

DeepSeek-Coder

2024年1月25日,发布DeepSeek-Coder,DeepSeek Coder由一系列代码语言模型组成,每个模型均从零开始在2万亿token上训练,数据集包含87%的代码和13%的中英文自然语言。代码模型尺寸从1B到33B版本不等。DeepSeek Coder在多种编程语言和各种基准测试中达到了开源代码模型的最先进性能。DeepSeek LLM的主要特征有如下:

海量的训练数据:从零开始在拥有2万亿token的数据集上进行了训练,数据集包括87%的代码和13%的中英文语言数据。

高度灵活性和可扩展:有1B、5.7B、6.7B、33B四种规格可供选择,用户可根据需要选择最合适的模型及规格

卓越的模型性能:在HumanEval、MultiPL-E、MBPP、DS-1000、与APPS多种基准测试中,与其他公开、可用的大模型相比,此模型总体上拥有更卓越的性能

高阶代码补全能力:采用16K的窗口大小和额外的填空任务进行训练,以支持项目级代码补全和填充。

其他详细介绍参考:DeepSeek-Coder的代码仓库

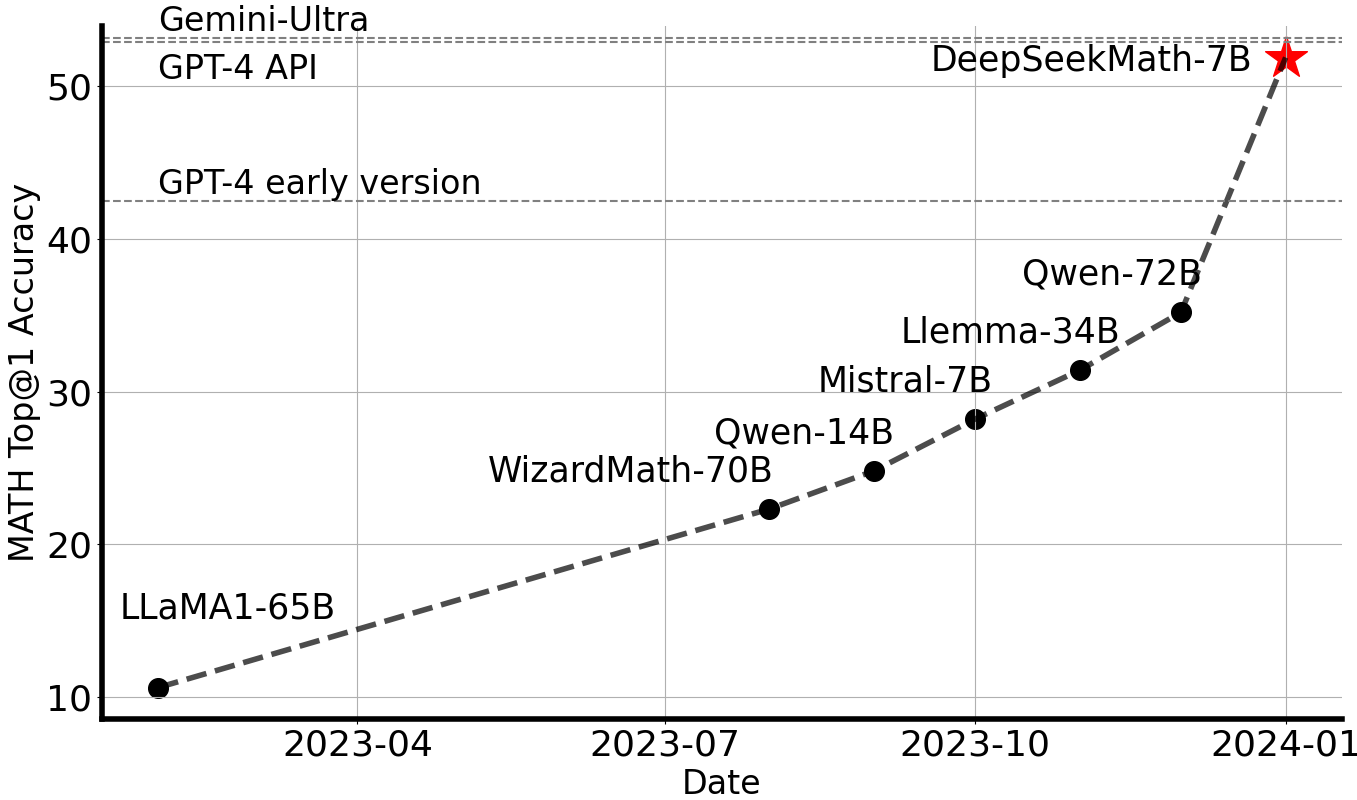

DeepSeekMath

2024年2月5日,发布DeepSeekMath,DeepSeekMath以DeepSeek-Coder-v1.5 7B为基础,继续在从Common Crawl中提取的数学相关token以及自然语言和代码数据上进行预训练,训练规模达5000亿token。DeepSeekMath 7B在竞赛级MATH基准测试中取得了51.7%的优异成绩,且未依赖外部工具包和投票技术,接近Gemini-Ultra和GPT-4的性能水平。

其他详细介绍参考:DeepSeek-Math的代码仓库

DeepSeek-VL

2024年3月11日,发布DeepSeek-VL。DeepSeek-VL 是一个开源的视觉语言模型,专为现实世界的视觉和语言理解应用而设计。DeepSeek-VL具有通用的多模态理解能力,能够处理逻辑图、网页、公式识别、科学文献、自然图像和复杂场景下的具身智能,同时保持相对较低的计算开销。DeepSeek-VL系列(包括1.3B和7B模型)在相同模型尺寸下,在广泛的视觉-语言基准测试中达到了最先进或可竞争的性能。

其他详细介绍参考:DeepSeek-VL的代码仓库

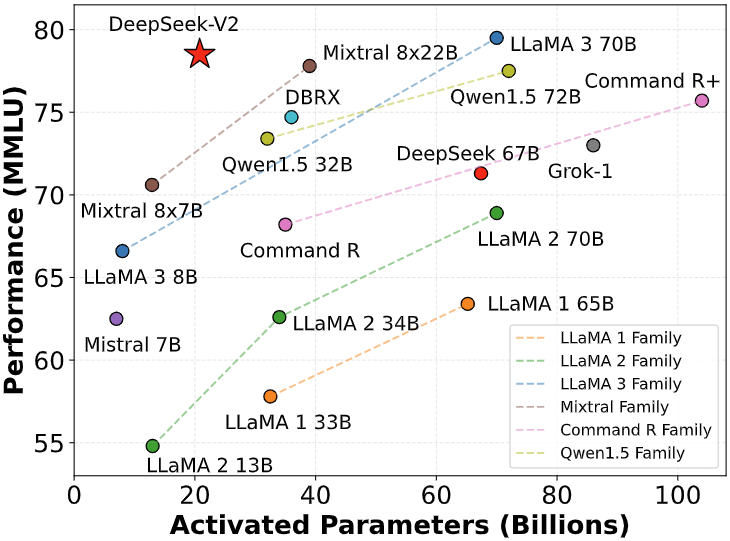

DeepSeek-V2

2024年5月7日,发布第二代开源Mixture-of-Experts(MoE)模型——DeepSeek-V2。DeepSeek-V2是一个强大的混合专家(MoE)语言模型,以经济高效的训练和推理为特点。它包含2360亿个总参数,其中每个token激活210亿个参数。与DeepSeek 67B相比,DeepSeek-V2不仅实现了更强的性能,同时还节省了42.5%的训练成本,将KV缓存减少了93.3%,并将最大生成吞吐量提升至5.76倍。DeepSeek-V2是在一个包含8.1万亿token的多样化且高质量的语料库上进行的预训练。在完成全面的预训练后,通过监督微调(SFT)和强化学习(RL)进一步释放了模型的潜力。评估结果验证了方法的有效性,DeepSeek-V2在标准基准测试和开放式生成评估中均取得了显著的表现。 DeepSeek V2模型因在中文综合能力评测中的出色表现,且以极低的推理成本引发行业关注,被称为“AI界的拼多多”。

其他详细介绍参考:DeepSeek-V2的代码仓库

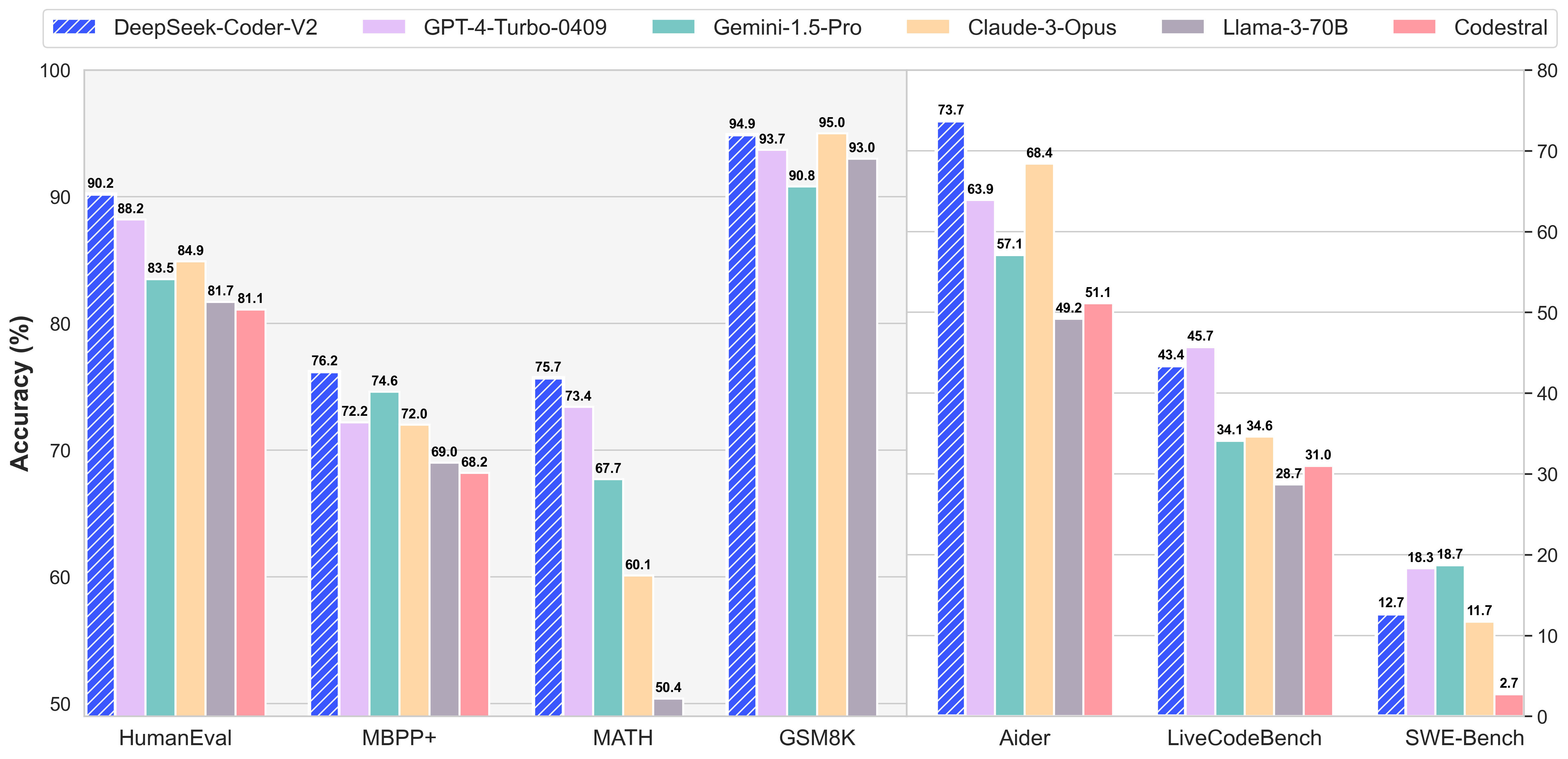

DeepSeek-Coder-V2

2024年6月17日,发布DeepSeek-Coder-V2,DeepSeek-Coder-V2是一个开源的混合专家(MoE)代码语言模型,在代码特定任务中达到了与GPT4-Turbo相当的性能。DeepSeek-Coder-V2是从DeepSeek-V2的一个中间检查点开始,进一步预训练了额外的6万亿token,显著增强了DeepSeek-V2的编码和数学推理能力,同时在通用语言任务中保持了相当的性能。并在代码相关任务、推理能力和通用能力等多个方面都取得了显著进步。此外,DeepSeek-Coder-V2将支持的编程语言从86种扩展到338种,并将上下文长度从16K扩展到128K。在标准基准测试中,DeepSeek-Coder-V2在编码和数学基准测试中表现优异,超越了GPT4-Turbo、Claude 3 Opus和Gemini 1.5 Pro等闭源模型。

其他详细介绍参考:DeepSeek-Coder-V2的代码仓库

DeepSeek-VL2

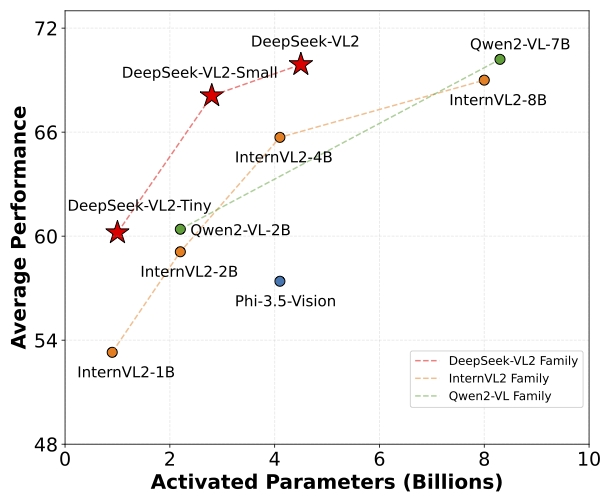

2024年12月13日,发布用于高级多模态理解的专家混合视觉语言模型——DeepSeek-VL2,DeepSeek-VL2是一个先进的大型混合专家(MoE)视觉-语言模型系列,相较于其前身DeepSeek-VL有了显著改进。DeepSeek-VL2在多种任务中展现了卓越的能力,包括但不限于视觉问答、光学字符识别、文档/表格/图表理解以及视觉定位。模型系列由三个变体组成:DeepSeek-VL2-Tiny、DeepSeek-VL2-Small和DeepSeek-VL2,分别具有10亿、28亿和45亿激活参数。与现有的开源密集模型和基于MoE的模型相比,DeepSeek-VL2在相似或更少的激活参数下实现了具有竞争力或最先进的性能。

其他详细介绍参考:DeepSeek-VL2的代码仓库

DeepSeek-V3

2024年12月26日晚,DeepSeek公司正式上线全新系列模型 DeepSeek-V3 首个版本并同步开源。

后面将有一个单独的章节对此模型做一个详细的介绍。

DeepSeek-R1

2025年1月20日,DeepSeek正式发布 DeepSeek-R1 模型,并同步开源模型权重。

后面也有一个单独的章节对此模型做一个详细的介绍。

DeepSeek-Janus-Pro

2025年1月28日凌晨,DeepSeek 在 GitHub 上的 Janus 项目空间官宣开源了 Janus-Pro 模型和技术报告。

DeepSeek-Janus-Pro的特征如下:

- Janus-Pro 模型是一个多模态模型,可以同时进行多模态理解和图像生成任务。它共有2个参数量版本,Janus-Pro-1B 及 Janus-Pro-7B。

- Janus-Pro 的核心创新是将多模态理解和生成,两种不同的任务解耦。让这两种任务可以在同一模型中高效完成。

- Janus-Pro 与去年10月 DeepSeek 发布的 Janus 模型架构一致,但当时 Janus 没有太多关注与关注。

- DeepSeek官方介绍,Janus-Pro 不仅能理解图片、对图片中的文字进行提取与理解,还能同时生成图片。

其他详细介绍参考:Janus的代码仓库

三、DeepSeek-V3 模型

2024年12月26日晚,DeepSeek公司正式上线全新系列模型 DeepSeek-V3 首个版本并同步开源。

论文下载查看:https://github.com/deepseek-ai/DeepSeek-V3/blob/main/DeepSeek_V3.pdf 或 https://arxiv.org/abs/2412.19437 。

以下关于DeepSeek-V3模型的阐述,来看DeepSeek-V3的github仓库内容的翻译。

3.1 模型介绍

是一个强大的专家混合(MoE)语言模型,具有671B个总参数,每个令牌激活37B个参数。为了实现高效的推理和低成本的训练,DeepSeek-V3采用了多头潜注意(MLA)和DeepSeekMoE架构,这两种架构在DeepSeek-V2中得到了充分的验证。此外,DeepSeek-V3开创性提出以下两点:无辅助损失策略、多令牌预测。DeepSeek-V3在14.8万亿个不同的高质量令牌上进行了预训练,然后进行监督微调和强化学习。据DeepSeek官网所述:综合性实验评估表明,DeepSeek-V3优于其他开源模型,并实现了与领先的闭源模型相当的性能。而实现如此优异性能的条件是,DeepSeek-V3的完整训练只花费了 278.8 m H800 GPU小时。此外,DeepSeek-V3的训练过程非常稳定,在整个训练过程中没有经历任何不可恢复的损失峰值或执行任何回滚。

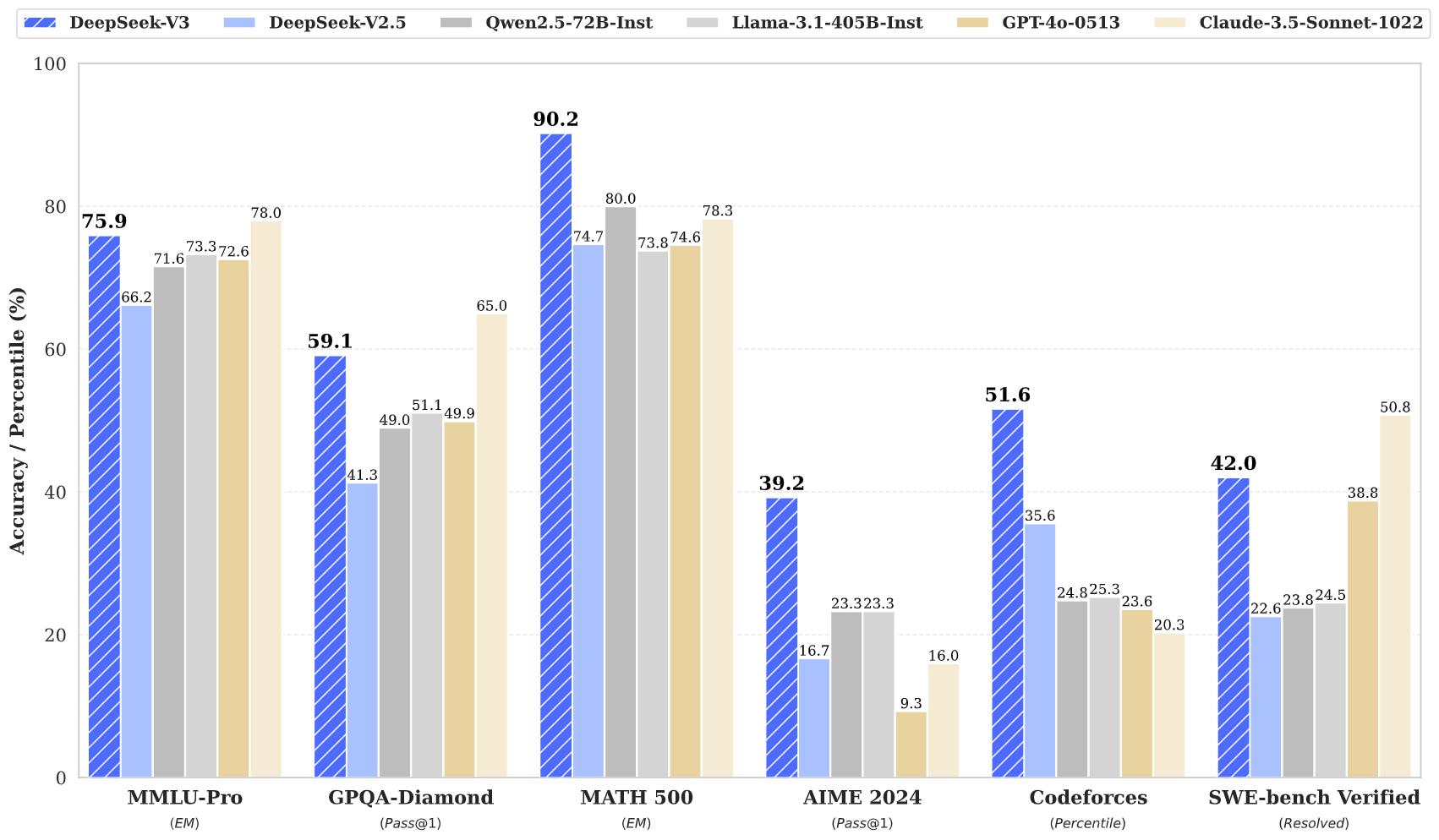

从下图(来自DeepSeek-V3在github上的代码仓库)可以看出,DeepSeek-V3在知识类任务(MMLU, MMLU-Pro, GPQA, SimpleQA)上的水平相比前代 DeepSeek-V2.5显著提升,接近当前表现最好的由Anthropic公司于10月发布的模型Claude-3.5-Sonnet-1022。在美国数学竞赛(AIME 2024, MATH)上,DeepSeek-V3很大程度地超过了其他所有开源闭源模型。在codeforces测评中,DeepSeek-V3大幅超过其他模型。另外,在生成速度上,DeepSeek-V3的生成吐字速度从20TPS(Transactions Per Second)大幅提高至60TPS,相比V2.5模型实现了3倍的提升,能够带来更加流畅的使用体验。

3.2 模型摘要

架构:采用创新的负载均衡策略与训练目标

DeepSeek-V3开创了一种无辅助损失的负载平衡策略,并为更强性能设置了多tokens预测训练目标。

- 在DeepSeek-V2的高效构架基础上,DeepSeek-V3开创性地提出了一种无辅助损失的负载均衡策略,这种策略可以最小化由追求负载均衡而引起的性能下降。

- DeepSeek-V3提出了一种多令牌预测(MTP)目标,事实证明它能提升模型性能。此外它能应用于推测解码以加速推理过程。

预训练:极高的训练效率

- DeepSeek-V3设计了一个FP8混合精度训练框架,并首次验证了FP8训练在超大规模模型上的可行性与有效性。

- 通过对算法、框架与硬件的协同考量与设计,DeppSeek-V3克服了跨节点MoE训练的通信瓶颈,几乎达到了计算与通信二者的完全一致性。这显著地提升了训练效率并减少了训练成本,使得研究人员与用户可以进一步扩展模型规模而无需其他额外的开销。

- 在仅仅2.664M(百万) 个H800 GPU小时的经济与时间成本条件下,在14.8T(万亿)个tokens上完成了DeepSeek-V3的预训练,由此创建出这一当时最强大(针对DeepSeek公司当时开源它们的DeepSeek-V3 模型时的时间点来说)的开源基础模型(应该是指DeepSeek-V3-Base)。预训练之后的后续训练阶段仅花费了0.1M(百万)个GPU小时(此处的GPU应该仍然是指H800)。

后训练:从DeepSeek-R1中蒸馏知识

通过引入一种创新的方法,从长思维链模型(特别是DeepSeek-R1系列模型中的某个)蒸馏与提取推理能力到普通的LLMs(大语言模型,此处特指DeepSeek-V3)。在整个后训练工作流程中,通过优雅地将DeepSeek-R1的验证与反思模式集成到DeepSeek-V3 中,显著地提升了DeepSeek-V3 的推理性能。与此同时,DeepSeek-V3 的输出风格与输出长度仍处于可控范围内。

3.3 模型下载

| Model | #Total Params | #Activated Params | Context Length | Huggingface 下载 | 魔搭下载 |

|---|---|---|---|---|---|

| DeepSeek-V3-Base | 671B | 37B | 128K | 🤗 Hugging Face | modelscope |

| DeepSeek-V3 | 671B | 37B | 128K | 🤗 Hugging Face | modelscope |

3.4 具体评估结果

参考:https://github.com/deepseek-ai/DeepSeek-V3?tab=readme-ov-file#4-evaluation-results

四、DeepSeek-R1模型

2025年1月20日,DeepSeek正式发布 DeepSeek-R1 模型,并同步开源模型权重。DeepSeek-R1在后训练阶段大规模使用了强化学习技术,在仅有极少标注数据的情况下,极大提升了模型推理能力。 DeepSeek-V3和DeepSeek-R1两款模型,成本价格低廉,性能与OpenAI-O1模型相当,引起了包括美国硅谷在内的多家知名顶尖AI公司的震惊与兴趣。

论文下载查看:https://github.com/deepseek-ai/DeepSeek-R1/blob/main/DeepSeek_R1.pdf 或 https://arxiv.org/pdf/2501.12948 。

以下关于DeepSeek-R1模型的阐述,来自DeepSeek-R1的github仓库内容的翻译。

4.1 模型介绍

DeepSeek-R1-Zero 与 DeepSeek-R1这两个模型是同时开源的,DeepSeek-R1-Zero 是 DeepSeek-R1的基础。

DeepSeek-R1-Zero模型是一个没有事先进行任何(supervised fine-tuning,SFT)监督微调而只通过大规模强化学习(einforcement learning,RL)训练得到的模型,最终结果证明DeepSeek-R1-Zero模型展示了卓越的推理能力。但事实上,DeepSeek-R1-Zero模型并不是十全十美,它也有一些显著的不足比如无穷止的重复、糟糕的可读性、语言混合输出等。为了解决这些不足并进一步强化推理能力与提升性能,DeepSeek-R1被训练出来。DeepSeek-R1通过引入强化学习前的冷启动数据和多阶段训练流程,不仅解决前述部分问题,而且最终达到在数学、编码、推理等任务上与`OpenAI-o1-1217 模型相媲美的水平。

为了对研究社区进行支持,DeepSeek 在开源了DeepSeek-R1-Zero 与

DeepSeek-R1这两个模型的同时,DeepSeek公司在DeepSeek-R1模型生成的样本数据的基础上对Llama或Qwen模型进行了微调与蒸馏,最终产生了6个性能卓越的蒸馏模型并且它们也被开源推出。其中蒸馏模型DeepSeek-R1-Distill-Qwen-32B在多项基准测试中的表现超过了OpenAI-o1-mini,不失为一个性能卓著的稠密模型(DeepSeek公司自己的评价。单从基准测试结果上来看,确实是这样)。

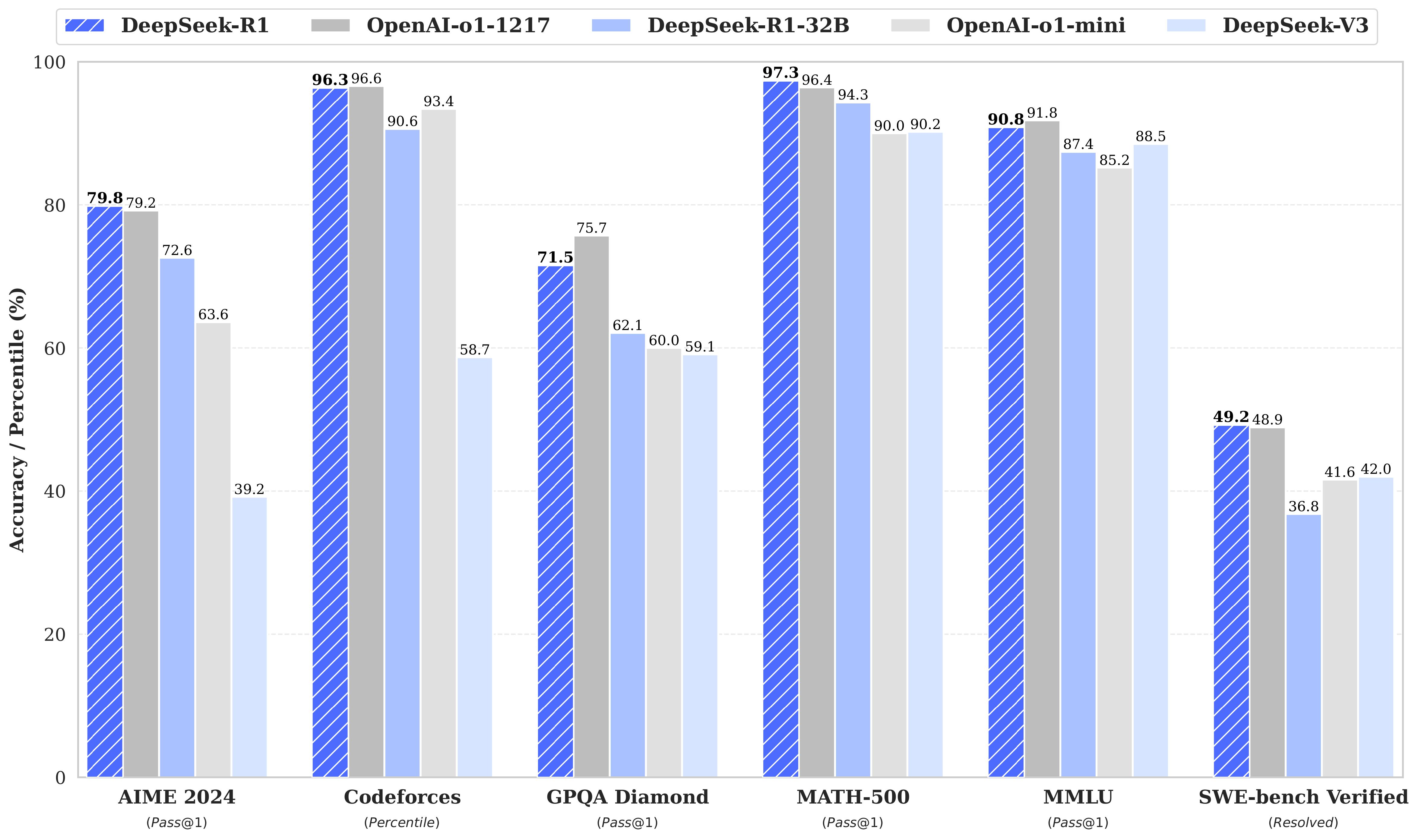

从下图(来自DeepSeek-R1在github上的代码仓库)可以看出,DeepSeek-R1在知识类任务(MMLU, MMLU-Pro, GPQA, SimpleQA)上的水平相比前面的最强模型 DeepSeek-V3 稍有提升,超过其他绝大多数模型,略逊于当前表现最好的由openai公司于前一年12月发布的模型OpenAI-o1-1217。在美国数学竞赛(AIME 2024, MATH)上,DeepSeek-R1超过所有开源闭源模型,略胜于OpenAI-o1-1217。在codeforces测评即编码相关的任务中,DeepSeek-R1在代码竞赛任务中表现出专家水平,获得了2029 Elo评级,在竞赛中表现优于96.3%的人类参与者,超过其他绝大多数模型。对于工程相关的任务(SWE-bench Verified),DeepSeek-R1的表现略优于OpenAI-o1-1217。

4.2 模型摘要

后训练:基于基础模型进行大规模强化学习

- 我们事先没有依赖监督微调,而是直接在基础模型上实施了强化学习。这种方法允许模型探索思维链去解决复杂问题,最终训练出DeepSeek-R1-Zero 模型。DeepSeek-R1-Zero 在展现了多方面的能力比如自我验证、反思与生成长思维链,这成为科研社区的一个重要的里程碑。特别地,这是第一个验证了“没有监督微调,LLM的推理能力也可以仅通过强化激励出来”的开源研究。这个突破为未来这个领域的进步铺就了道路。

- 我们引入了一个工作流水线来研发DeepSeek-R1。这个流水线采用了两个强化学习阶段,它们旨在探索更加准确高效的推理模式、符合人类偏好,同时也采用了两个监督微调阶段作为模型推理和非推理能力的种子。

蒸馏:小模型也能拥有大智慧

- 我们证明了大模型的的推理模式可以被蒸馏到更小的模型中,而且小模型的推理模式比直接在小模型上实施强化而得到的推理模式更优。开源的DeepSeek-R1及其API将有助于科研界在未来蒸馏出更小更好的模型。

- 使用DeepSeek-R1生成的推理数据,我们对几个在科研界被广泛使用的的稠密模型。评估结果表明,蒸馏出来的小型稠密模型在基准测试中的表现出人意料地好。DeepSeek公司在Qwen2.5 或 Llama3模型的基础上蒸馏出了1.5B、7B、8B、14B、32B 和 70B 这6个不同参数规模的模型,并将它们全部开源给了社区。

4.3 模型下载

DeepSeek-R1 模型

| Model | #Total Params | #Activated Params | Context Length | Huggingface 下载 | 魔搭下载 |

|---|---|---|---|---|---|

| DeepSeek-R1-Zero | 671B | 37B | 128K | 🤗 HuggingFace | modelscope |

| DeepSeek-R1 | 671B | 37B | 128K | 🤗 HuggingFace | modelscope |

DeepSeek-R1-Zero 与 DeepSeek-R1 都是从DeepSeek-V3-Base 这一模型训练而来.

DeepSeek-R1 的蒸馏模型

| Model | Base Model | Huggingface 下载 | 魔搭下载 |

|---|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | 🤗 HuggingFace | modelscope |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | 🤗 HuggingFace | modelscope |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | 🤗 HuggingFace | modelscope |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | 🤗 HuggingFace | modelscope |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | 🤗 HuggingFace | modelscope |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | 🤗 HuggingFace | modelscope |

上述 DeepSeek-R1-Distill-XXX 这些都是对同等参数规模的DeepSeek-R1 进行微调与蒸馏而得到的,它们(这些蒸馏模型)使用的数据都是由DeepSeek-R1 生成的。在微调与蒸馏出模型时,它们的配置与tokenizers都有被或多或少的改变过,使用这些模型时需要注意。

4.4 具体评估结果

参考:https://github.com/deepseek-ai/DeepSeek-R1?tab=readme-ov-file#4-evaluation-results

五、专业名词解释

AGI

英文全称是“artificial general intelligence”,中文翻译为“通用人工智能”,也叫强人工智能(英语:strong AI)。是指具备与人类同等智能、或超越人类的人工智能,能表现正常人类所具有的所有智能行为。

-

英文全称是”Mixture of Experts“,中文翻译为”混合专家模型“,起源于1991 年的论文Adaptive Mixture of Local Experts。混合专家模型 (MoE) 的一个显著优势是它们能够在远少于稠密模型所需的计算资源下进行有效的预训练。这意味着在相同的计算预算条件下,您可以显著扩大模型或数据集的规模。特别是在预训练阶段,与稠密模型相比,混合专家模型通常能够更快地达到相同的质量水平。

蒸馏

此处的蒸馏当然不是我们初中物理学习的蒸馏技术,此处是指蒸馏技术,它就像是学校里的学习过程:老师拥有丰富的知识和经验,学生通过学习老师的知识逐渐成长。AI中的“教师模型”相当于知识渊博的老师,它通过大量的数据训练,掌握了复杂的模式和特征;而“学生模型”则像是一个刚刚起步的学生,虽然知识面不如老师丰富,但通过学习老师的“思考方式”和“经验”,可以在没有过多计算资源的情况下取得不错的成绩。以个人目前的知识来理解,就像是应试教育与考试。

也就是说,蒸馏是一种从已有的模型(当然我们会尽可能采用业界最高水准的模型)中提取知识的方法:你可以给教师模型(teacher model)输入数据,记录它的输出,并用这些数据训练学生模型(student model)。

一般来说,公司只能对自己的模型进行蒸馏,因为公司对自己的模型拥有所有的归属权与访问控制权限。一般地对商业公司发布的进行蒸馏的方法就是通过不断、反复调用其API接口,记录输入输出,达到对此商业模型进行蒸馏的目的;但对商业公司发布的受商业条款保护的模型进行蒸馏是非法的,商业公司也是严查严防此类行为,通常通过限制API访问(如同一IP在单位时间内访问API的频率等),甚至直接封禁访问IP,但这仍然是一种普遍存在的训练策略,因此我们才看到越来越多的模型在逼近GPT-4o(GPT-4o就是通过此方法从GPT-4演化而来的)的质量。

-

在人工智能领域,模型可以分为稀疏和稠密两种类型。稀疏模型通常是指神经网络中大部分参数都是零或非常接近零的模型,而稠密模型则是指神经网络中参数分布较为均匀的模型。

稀疏语言模型是一种基于稀疏编码的模型,主要用于自然语言处理任务,如文本分类、情感分析等。该模型利用了语言本身的语法和语义结构,通过将文本分解为一系列词组或短语,然后对这些词组或短语进行编码,最后再利用这些编码进行分类或情感分析。由于稀疏语言模型可以自动地识别文本中的关键词和短语,因此在处理自然语言任务时具有较好的效果。

稀疏优化模型是指基于稀疏性的优化算法,其基本思想是通过引入稀疏性约束来优化目标函数。这种优化算法可以在大规模数据集上找到更具有代表性的特征,从而更好地进行分类或回归等任务。稀疏优化算法在机器学习领域有着广泛的应用,如支持向量机、随机森林等算法中都使用了稀疏性约束。

稠密模型则是神经网络中最为常见的模型之一,其特点是每个神经元都与输入数据中的每个元素相连,因此可以处理任意形式的输入数据。稠密模型在图像识别、语音识别等领域有着广泛的应用。由于稠密模型中参数分布较为均匀,因此在训练过程中可以充分利用GPU等硬件加速器进行并行计算,从而提高训练速度。

六、其他信息与相关事件

6.1 被雷军挖角的天才少女罗福莉

2024年12月份,雷军以千万级薪酬招揽DeepSeek核心研究员、95后AI天才罗福莉。期望她能领军小米AI大模型团队的发展。

6.2 2025年1月27日DeepSeek网页/API不可用

6.3 DeepSeek登顶中美应用下载榜首

2025年1月27日,DeepSeek应用登顶苹果美国地区应用商店免费APP下载排行榜,在美区下载榜上超越了ChatGPT。同日,苹果中国区应用商店免费榜显示,DeepSeek成为中国区第一。

6.4 国内知名公司纷纷接入DeepSeek

DeepSeek横空出世激起千层浪。近日,金山云、荣耀手机、东风汽车等纷纷宣布接入DeepSeek。部分名单与细节参考: DeepSeek真香!三大运营商、商汤等已接入,名单还在扩大 。最终结果让市场来检验。

6.5 国产加速卡纷纷加速适配DeepSeek

DeepSeek-V3及DeepSeek-R1爆火后,国产加速卡厂商如华为昇腾、壁仞科技、天数智芯、摩尔线程、龙芯中科、昆仑芯等纷纷加速适配DeepSeek。最终结果让市场来检验。

七、思考与总结

- 大模型现在已经进入爆发阶段,作为一个IT人,如果不转行就只能向其靠近,不断学习大模型的原理、研发与使用。

- 模型蒸馏技术并不是DeepSeek公司发明的,但确是它们开源DeepSeek-V3与DeepSeek-R1及相关蒸馏模型后引发科研人员与研发人员关注的,所以专注于当前的某件事情将其做精,也能取得一定的“成功”。

- 从2024年12月底到现在,一个半月左右时间过去了,国内越来越多的大公司开源拥抱、研究DeepSeek开源的基础模型及其蒸馏模型,接入这些模型到自己的云产品或人工智能或智算产品中,这些产品水平肯定是各有特色,用户要根据自己需要与条件选择适合自己的产品;此外这些产品的水平肯定参差不齐的,现在不管大公司还是小公司都说自己的产品接入DeepSeek相关模型,最终还需要我们去实地检验它们是真可用,还是说在跟风追逐噱头。

- 越来越多的国产加速卡也开始适配DeepSeek模型,真正的适配成功要真实、高效、可用性好才行,这样才能吸引用户、打开市场、扩大生态,最终突破美国对我们此类硬件设备的封锁管控,形成我们国家自己硬实力与特色。拭目以待吧!

- 其他很多概念与原理机制,暂时无法全部理解与解释到位,有待后续继续学习与记录。