Transformer模型中专业名词

1.词元(Token)

是输入文本经过分词后的离散符号,表示模型处理的最小单位。

定义:词元是输入文本经过 分词(Tokenization) 后得到的基本单位。它可以是单词、子词(Subword)或字符,具体取决于使用的分词方法。

作用:词元是模型处理的最小单位,用于将文本转换为模型可以理解的离散符号。

示例:

- 对于句子

"I love NLP.",使用空格分词后,词元可能是["I", "love", "NLP", "."]。 - 使用子词分词(如 BPE)后,词元可能是

["I", "love", "NL", "##P", "."]。

- 对于句子

2.词向量(Word Embedding)

是词元经过嵌入层后的连续向量表示,用于捕捉词元的语义信息。

作用:词向量将离散的词元转换为连续的数值表示,便于模型进行计算和学习。

示例:

- 假设词元

"love"被映射到一个 3 维向量空间,其词向量可能是[0.2, 0.8, -0.3]。 - 词向量通常是通过预训练(如 Word2Vec、GloVe)或模型训练(如 Transformer)得到的。

- 假设词元

词元与词向量的关系

- 输入与输出:

- 词元是模型的输入,表示文本的离散符号。

- 词向量是词元经过嵌入层(Embedding Layer)后的输出,表示词元的连续向量表示。

- 转换过程:

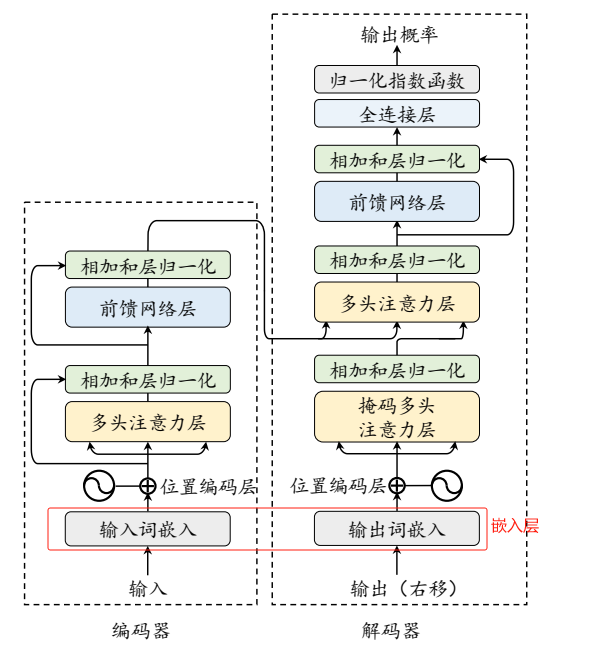

- 在 Transformer 中,输入文本首先被分词为词元。

- 然后,词元通过嵌入层被转换为词向量。

- 之后词向量作为模型的输入,参与后续的计算(如自注意力机制)。

- 输入与输出:

示例

假设输入句子为

"I love NLP.":词元化:

- 分词结果为

["I", "love", "NLP", "."]。

- 分词结果为

词向量化:

每个词元被映射为一个词向量,例如:

"I"→[0.1, 0.3, -0.2]"love"→[0.2, 0.8, -0.3]"NLP"→[0.4, -0.1, 0.5]"."→[-0.1, 0.0, 0.1]

3.旋转矩阵等相关

旋转矩阵、索引为i的旋转矩阵、索引为i的旋转矩阵与索引为j的旋转矩阵转置相乘?

Transformer模型中专业名词

https://jiangsanyin.github.io/2025/03/22/Transformer模型中专业名词/